De los Píxeles a la Personalización: Cómo HunyuanCustom de Tencent Está Redefiniendo la Generación de Video con IA

La Revolución Silenciosa en la Creación de Video con IA

El 8 de mayo de 2025, Tencent lanzó una importante actualización al mundo de la IA generativa, y la mayoría de la gente no se dio cuenta. Pero si trabajas en marketing, medios, comercio electrónico o inversión en IA, HunyuanCustom es un nombre que querrás recordar. Este lanzamiento no es solo otro modelo en el abarrotado panorama de las herramientas de generación de video, es un cambio a nivel de infraestructura. El modelo ofrece algo que ninguna plataforma abierta o cerrada ha entregado de manera convincente a gran escala: personalización de video multimodal con consistencia de identidad.

En un mundo cada vez más dominado por los medios sintéticos, mantener la autenticidad de una persona digital a través de fotogramas, acciones y entradas no es solo un desafío técnico, es una necesidad empresarial. Ya sea que estés desplegando un embajador de marca digital, animando la imagen de un famoso o reemplazando personajes en contenido de video sin volver a grabar, la consistencia de identidad es la variable que decide el éxito o el fracaso.

HunyuanCustom aborda esto directamente con una serie de innovaciones arquitectónicas. ¿El resultado? Un gran avance en control, personalización y coherencia visual: tres pilares del contenido sintético escalable.

¿Por Qué Es Importante Ahora?

El video ya representa más del 80% del tráfico de internet. La IA generativa se está utilizando para acelerar todo, desde la producción de anuncios y la creación de avatares hasta instructores virtuales y demostraciones de productos animadas. Pero hasta ahora, un problema ha limitado su adopción más amplia: la inconsistencia. Los rostros cambian a través de los fotogramas. El audio no coincide con el movimiento de los labios. La identidad se desdibuja en movimiento.

HunyuanCustom de Tencent aborda estos fallos de frente, integrando entradas de control multimodal (texto, imágenes, audio, video) y uniéndolas en una salida consistente y controlada. Es más que una simple mejora de funciones, es una mejora de infraestructura sobre la que se puede construir.

Para los inversores, el mensaje es claro: HunyuanCustom está posicionado para ser un modelo fundamental para contenido de video con IA de grado comercial. Y su compromiso con el código abierto podría inclinar la balanza en las dinámicas futuras de cuota de mercado.

Dentro de la Arquitectura: ¿Qué Hace Diferente a HunyuanCustom?

Analicemos las innovaciones clave y por qué son importantes para desarrolladores y usuarios empresariales:

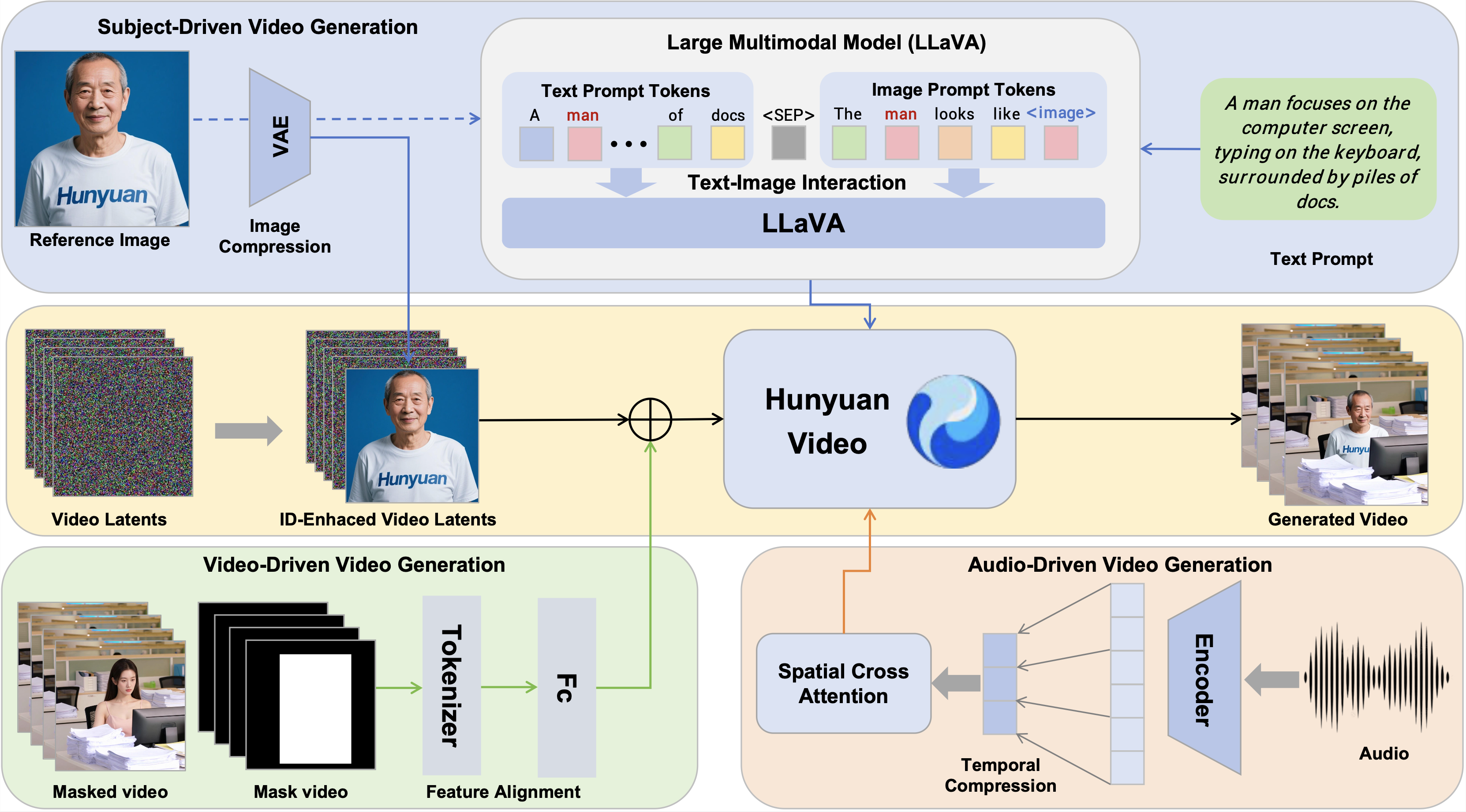

1. Condicionamiento Multimodal que Funciona

A diferencia de muchos predecesores que fallan con combinaciones complejas de entradas, HunyuanCustom fusiona texto, imágenes, audio y video en una salida coherente. Ya sea que quieras un gemelo digital parlante de un CEO o un modelo de ropa reaccionando al sonido ambiental, este modelo puede manejarlo.

📌 Innovación clave: La Fusión Texto-Imagen basada en LLaVA crea una comprensión unificada de la identidad visual y la instrucción verbal, algo crítico para el movimiento y la expresión naturales.

2. Motor de Consistencia de Identidad

En el corazón del sistema se encuentra el Módulo de Mejora de ID de Imagen. Utilizando latentes VAE y incrustaciones posicionales 3D, propaga la identidad de un sujeto a través de los fotogramas de video sin simplemente "copiar y pegar" características faciales. Esto asegura que el sujeto permanezca reconocible bajo movimiento, oclusión o cambios de expresión.

📌 Por qué es importante: Los modelos anteriores sufrían de vibración (jitter) y pérdida de identidad con el tiempo. Las mejoras de consistencia temporal de HunyuanCustom solucionan esto.

3. Audio Sin Desviación

En los modelos tradicionales, inyectar audio para sincronizar los labios a menudo degrada la identidad visual del sujeto. La solución de Tencent: el AudioNet de Identidad Desvinculada, que aplica atención cruzada espacial por fotograma, asegurando una sincronización precisa sin distorsión visual.

📌 Relevancia para el negocio: Permite avatares virtuales con sonido natural para atención al cliente, e-learning o marketing interactivo.

4. Edición Rápida y Eficiente Basada en Video

HunyuanCustom también permite usar videos existentes como fuentes de entrada; por ejemplo, reemplazando un personaje de fondo o insertando un nuevo portavoz en un anuncio previamente grabado.

📌 Avance técnico: Su Módulo de Inyección Impulsado por Video añade características codificadas de videos de referencia directamente al flujo de generación con mínima sobrecarga computacional.

Evaluando la Expectativa: ¿Es Realmente Mejor?

En comparaciones técnicas contra plataformas tanto de código abierto como comerciales como Vidu, Pika, Keling y Skyreels, HunyuanCustom lidera en múltiples aspectos.

| Modelo | Face-Sim (↑) | DINO-Sim (↑) | Consistencia Temp (↑) |

|---|---|---|---|

| Vidu 2.0 | 0.424 | 0.537 | 0.961 |

| Keling 1.6 | 0.505 | 0.580 | 0.914 |

| Pika | 0.363 | 0.485 | 0.928 |

| HunyuanCustom | 0.627 | 0.593 | 0.958 |

Estas cifras indican un modelo que supera a otros en preservación de identidad, realismo de escena y coherencia temporal. Eso no es solo una victoria técnica, es un facilitador para el negocio.

Aplicaciones del Mundo Real con Potencial Comercial

La fortaleza de HunyuanCustom reside en su adaptabilidad a través de diferentes casos de uso:

Publicidad y Marketing

Las marcas pueden desplegar embajadores digitales consistentes en campañas localizadas, completos con mensajes sincronizados con los labios en múltiples idiomas.

Probadores Virtuales y Comercio Electrónico

Las marcas de ropa pueden generar demostraciones de movimiento realistas a partir de imágenes fijas, reduciendo la dependencia de costosas sesiones de fotos.

Educación y Formación

Se pueden crear instructores de video personalizados para diferentes segmentos demográficos, manteniendo una calidad visual y tonal consistente.

Edición y Producción de Video

Los estudios ahora pueden adaptar metraje antiguo con nuevos personajes o mensajes sin volver a grabar o tener artefactos de deepfake.

Gaming y Metaverso

Se pueden animar avatares realistas a partir de entradas mínimas, desbloqueando la personalización de próxima generación para mundos virtuales.

Desafíos y Consideraciones para la Adopción

Si bien el rendimiento es prometedor, vale la pena mencionar algunos puntos a considerar: