NVIDIA Amplía Su Alcance mientras Meta y Oracle Adoptan Ethernet Spectrum-X para Impulsar Sistemas de IA de Próxima Generación

El Nuevo Campo de Batalla de Silicon Valley: La Audaz Jugada de NVIDIA para Reconectar el Sistema Nervioso de la IA

Meta y Oracle adoptan Ethernet Spectrum-X en una medida que podría rediseñar la arquitectura de la inteligencia artificial y poner a prueba los límites de la influencia de una sola compañía.

SAN JOSÉ, California. — Los centros de datos que impulsan el auge actual de la inteligencia artificial están chocando contra un muro. Sus redes neuronales son cada vez más grandes, pero las "tuberías" digitales que las conectan simplemente no pueden seguir el ritmo.

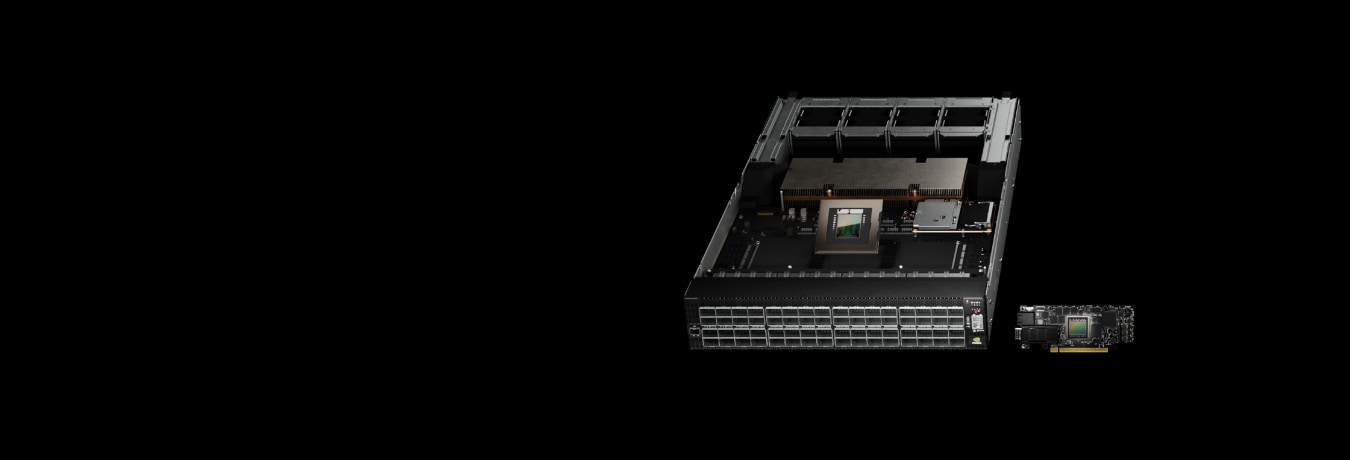

El lunes, NVIDIA reveló que tanto Meta como Oracle planean implementar sus conmutadores Ethernet Spectrum-X en su vasta infraestructura de IA. Esta medida extiende el dominio de NVIDIA más allá de los chips y directamente al tejido conectivo que permite que los sistemas de aprendizaje automático piensen y se comuniquen entre sí.

Es un gran paso para ambas compañías, aunque por diferentes razones. Meta, conocida por su enfoque de código abierto y múltiples proveedores, y Oracle, famosa por su integración estricta y todo en uno, rara vez siguen el mismo camino. Su voto de confianza compartido en NVIDIA marca un posible punto de inflexión en cómo los gigantes tecnológicos construyen lo que Jensen Huang, CEO de NVIDIA, llama "fábricas de IA".

Pero bajo la emoción subyace una pregunta a nivel de la industria: ¿el futuro de la IA funcionará con sistemas estrictamente controlados y verticalmente integrados, propiedad de un solo proveedor, o con estándares abiertos y flexibles que mantengan el mercado competitivo y a los compradores en control?

Cuando las Redes se Convierten en Cuellos de Botella

El problema se reduce a la física. A medida que los modelos de lenguaje actuales se disparan a billones de parámetros, dependen de miles de GPU que intercambian datos constantemente: actualizaciones de gradiente, pesos del modelo y todo lo demás. Ese vaivén ininterrumpido inunda la red con enormes ráfagas de tráfico.

El equipo Ethernet tradicional simplemente no fue diseñado para ese tipo de exigencia. Los analistas estiman que las redes típicas de los centros de datos alcanzan solo alrededor del 60% de rendimiento efectivo durante el entrenamiento de IA. El resto se ve absorbido por la congestión, los retrasos de búfer y las colisiones de tráfico. Cada punto porcentual perdido significa GPU inactivas: millones de dólares en hardware sin usar, "rascándose los pulgares digitales".

NVIDIA afirma que su sistema Spectrum-X cambia esa ecuación. Al combinar conmutadores diseñados específicamente con tarjetas de red personalizadas y software optimizado para IA, la compañía dice que puede aumentar la utilización al 95%. La plataforma predice dónde se formará la congestión y redirige los datos antes de que se convierta en un problema. Esos números, dice NVIDIA, provienen directamente de sus propias supercomputadoras, aunque la validación externa en configuraciones multi-proveedor del mundo real aún es limitada.

La Ecuación del Hiperescalador

De los dos adoptantes, el movimiento de Meta llama más la atención. La compañía prácticamente escribió el libro sobre redes abiertas, evitando la dependencia de un solo proveedor (vendor lock-in) al mezclar y combinar equipos de Broadcom, Arista y otros. Así que ver a Meta integrar la tecnología de NVIDIA en sus conmutadores Minipack3N y el software Facebook Open Switching System sugiere algo significativo: o el hardware de NVIDIA está realmente muy por delante, o Meta ha decidido que el rendimiento de la IA y el diseño de la red ya no pueden tratarse por separado.

Personas internas susurran que Meta no está "tirando el bebé con el agua del baño". En cambio, es probable que ejecute Spectrum-X junto con su infraestructura Broadcom existente, cubriendo sus apuestas mientras mantiene las opciones abiertas.

La jugada de Oracle, por el contrario, encaja con su patrón habitual. La compañía ha construido su estrategia en la nube en torno a una profunda colaboración con NVIDIA. Su adopción de Spectrum-X se alinea con la arquitectura de próxima generación "Vera Rubin", diseñada para conectar millones de GPU en lo que los socios llaman "fábricas de IA a gigaescala". Para Oracle, la lógica es simple: cuando la velocidad y la fiabilidad son lo más importante, la integración supera a la modularidad en todo momento.

El Contragolpe del Silicio Comercial

El impulso de NVIDIA no ha pasado desapercibido. Broadcom, cuyos chips forman la columna vertebral de gran parte de internet, recientemente consiguió un importante acuerdo de redes de IA con OpenAI, construido en torno a sus propios diseños optimizados para Ethernet. Cisco está impulsando sus chips Silicon One P200 para las conexiones de larga distancia que unen centros de datos a través de continentes, con Microsoft y Alibaba ya a bordo.

Mientras tanto, el Consorcio Ultra Ethernet —una alianza de peso pesado que incluye a AMD, Arista, Broadcom, Cisco, Intel, Meta y Microsoft— ha lanzado su especificación 1.0. ¿Su objetivo? Igualar el rendimiento de NVIDIA sin "encerrar" a los clientes con un solo proveedor. En otras palabras, es un ataque coordinado contra las pilas (stacks) propietarias.

Lo que está en juego no podría ser mayor. Los analistas esperan que las redes de IA para centros de datos generen entre 80 y 100 mil millones de dólares en ingresos por conmutadores durante los próximos cinco años. A medida que las velocidades de Ethernet saltan de 800 Gbps a 1.6 Tbps, el desafío de NVIDIA es claro: mantener su liderazgo mientras el resto de la industria se apresura a ponerse al día.

Analizando las Afirmaciones de Rendimiento

Esa afirmación de un rendimiento del 95% frente al 60% suena impresionante, pero el contexto importa. Los números de NVIDIA provienen de sus propios laboratorios de prueba, bajo condiciones ideales y cargas de trabajo ajustadas para su equipo. En el mundo real —donde las redes son desordenadas, mezcladas e impredecibles— los resultados pueden ser muy diferentes.

Los competidores tampoco se creen la historia completa. Ingenieros familiarizados con las implementaciones de Jericho4 de Broadcom dicen que sus sistemas pueden alcanzar tasas de eficiencia en los ochenta altos cuando se ajustan correctamente. La brecha restante, argumentan, tiene menos que ver con el hardware y más con cómo se arquitectan y optimizan las redes.

Aun así, no se puede negar la ventaja de NVIDIA en integración. Sus tarjetas de red, conmutadores, bibliotecas de software y controles de congestión operan como un organismo cohesivo. Eso es difícil de replicar en el ecosistema abierto, donde múltiples proveedores tienen que llevarse bien. Si los clientes aceptarán menos flexibilidad por ese aumento de rendimiento depende de cuánto valoren la libertad sobre la velocidad.

La Estrategia de la Escala Distribuida

La próxima frontera no son solo modelos más grandes, es distribuirlos. La nueva tecnología Spectrum-XGS de NVIDIA tiene como objetivo conectar centros de datos completos en clústeres de entrenamiento unificados y globales. A medida que los modelos se vuelven demasiado grandes para un solo sitio, y a medida que las granjas de GPU, hambrientas de energía, persiguen energía asequible en diferentes regiones, la capacidad de coordinar el entrenamiento a través de continentes se vuelve crucial.

Aquí, NVIDIA se enfrenta a Cisco directamente. El silicio de búfer profundo de Cisco está hecho a medida para el tráfico de IA de larga distancia. La batalla no se decidirá por las especificaciones puras, sino por lo bien que cada plataforma maneje la latencia y los fallos que conlleva la distribución de tareas de entrenamiento. Cuando sincronizas GPU a través de miles de kilómetros, incluso un pequeño fallo puede descarrilar una ejecución completa.

Perspectivas de Inversión y Señales Futuras

Para inversores y analistas, el ángulo de negocio es claro. Las redes podrían convertirse en el próximo gran motor de ganancias de NVIDIA. Más allá de los propios conmutadores, hay dinero en las tarjetas de red, la óptica y el "pegamento" de software que lo mantiene todo unido. Si NVIDIA acapara entre el 10 y el 20 por ciento del mercado de Ethernet para IA, los analistas dicen que podría generar ingresos anuales de decenas de miles de millones de dólares para 2027, con jugosos márgenes de alrededor del 35%.

Pero la competencia se está calentando rápidamente. La asociación de Broadcom con OpenAI demuestra que el silicio comercial (de terceros) sigue siendo importante. El impulso del Consorcio Ultra Ethernet por estándares abiertos podría presionar el poder de fijación de precios de NVIDIA en los próximos dos o tres años si se logra la paridad de rendimiento. Históricamente, los hiperescaladores como Meta prefieren comprar de múltiples fuentes, lo que sugiere que no entregarán las "llaves" a NVIDIA sin un plan de respaldo.

Para los fabricantes de equipos, los efectos dominó varían. Arista Networks se enfrenta a la amenaza más aguda ya que el hardware de NVIDIA ahora se superpone con su territorio. Cisco podría encontrar su nicho en la conectividad de larga distancia, pero necesitará moverse rápidamente. Broadcom sigue siendo resistente gracias a su diversa base de clientes, incluso si pierde algo de cuota en cuentas específicas de IA.

Puntos clave a observar: cómo se desempeñan las implementaciones de Meta y Oracle en el mundo real; cómo cambia la demanda de ópticas de 1.6 terabits; y si los reguladores comienzan a cuestionar el creciente control de NVIDIA sobre el ecosistema.

Y como siempre, los inversores deben recordar: el rendimiento pasado no es el destino. El panorama de las redes de semiconductores se mueve rápido, moldeado por los avances tecnológicos, las sorpresas competitivas y los cambios en los estándares. Mantenerse informado y diversificado no es solo inteligente, es esencial.

La Pregunta Abierta

Al final, el dilema central persiste. ¿Se consolidará la infraestructura de IA en torno a plataformas fuertemente integradas que persigan hasta la última gota de rendimiento? ¿O se mantendrá abierta, distribuida y competitiva?

El anuncio del lunes inclina el péndulo hacia la integración, pero también enciende la mecha del bando de los estándares abiertos. Ambas partes saben que la carrera no es solo por la velocidad pura, sino por quién controla la arquitectura de la propia era de la IA.

Lo que Meta y Oracle construyan a partir de aquí —y si mantienen la puerta abierta a alternativas— nos dirá qué visión triunfa en esta nueva era de inteligencia a gigaescala.

ESTO NO ES ASESORAMIENTO DE INVERSIÓN