La Apuesta de 100 mil millones de dólares: NVIDIA y OpenAI Forjan una Alianza que Podría Reconfigurar el Futuro de la IA

Alianza estratégica para infraestructura de 10 gigavatios marca una escala sin precedentes en la computación de inteligencia artificial, señalando un cambio de la industria hacia fábricas de IA intensivas en energía.

NVIDIA Corporation y OpenAI anunciaron el domingo una asociación estratégica histórica que verá al fabricante de chips invertir hasta 100 mil millones de dólares para implementar al menos 10 gigavatios de sistemas de IA para la infraestructura de próxima generación de OpenAI.

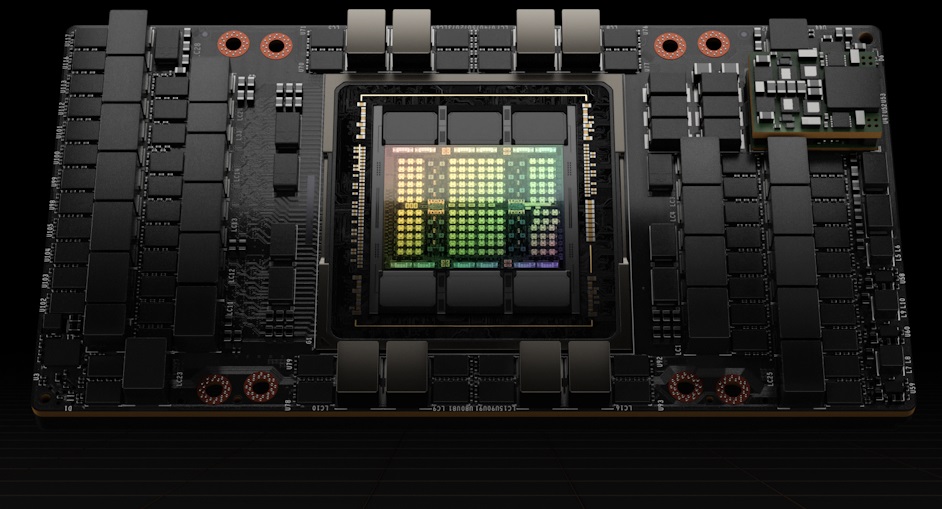

El acuerdo, formalizado mediante una carta de intención, representa uno de los compromisos de capital más significativos en la breve pero explosiva historia del sector de la IA. La asociación implementará progresivamente millones de GPU de NVIDIA a medida que OpenAI construya lo que los expertos de la industria describen como "fábricas de IA" diseñadas para entrenar y operar sistemas superinteligentes.

El primer gigavatio de capacidad tiene como objetivo entrar en funcionamiento en la segunda mitad de 2026, utilizando la próxima plataforma Vera Rubin de NVIDIA. Solo esta implementación inicial consumiría aproximadamente la misma cantidad de energía continua que una gran área metropolitana, lo que destaca la escala de infraestructura necesaria para el desarrollo de IA de vanguardia.

Cuando Silicon Valley se Encuentra con la Red Eléctrica

El compromiso de 10 gigavatios se traduce en aproximadamente 87.6 teravatios-hora de consumo de energía anual, equivalente al consumo eléctrico de países como Bélgica o Chile. Analistas de la industria estiman que esta infraestructura podría albergar entre 5.6 y 10.4 millones de aceleradores de GPU en múltiples campus de centros de datos, lo que representa un valor de hardware que podría superar los 400 mil millones de dólares.

Consumo de energía anual proyectado de 87.6 TWh de la infraestructura de IA de 10 gigavatios en comparación con el consumo anual de electricidad de países seleccionados.

| País/Infraestructura | Consumo Anual de Electricidad (TWh) |

|---|---|

| Infraestructura de IA | 87.6 |

| Chile | 83.3 |

| Bélgica | 78 |

| Noruega | 135.68 |

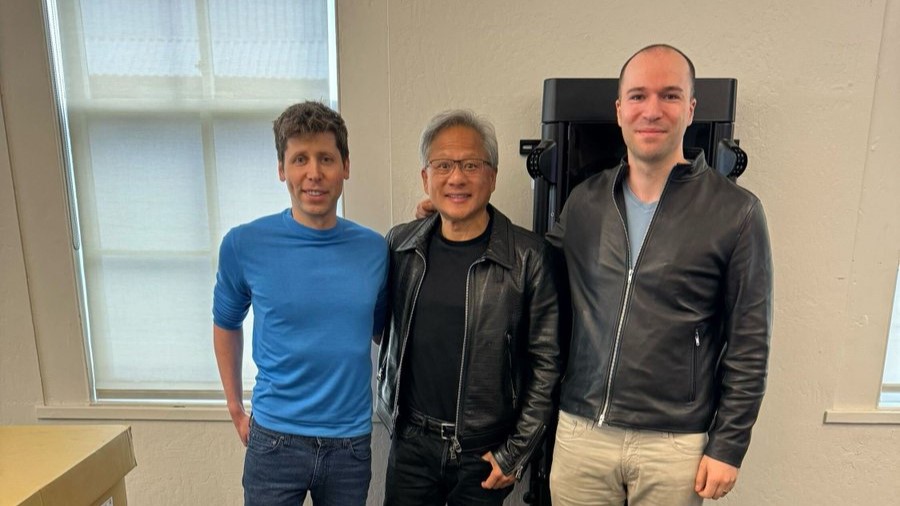

"Esta inversión y asociación de infraestructura marcan el siguiente salto adelante: implementar 10 gigavatios para impulsar la próxima era de la inteligencia", dijo Jensen Huang, fundador y CEO de NVIDIA, en el anuncio. Su homólogo, Sam Altman, CEO de OpenAI, enfatizó que "la infraestructura de computación será la base de la economía del futuro".

La estructura de la asociación revela una sofisticada ingeniería financiera. Según fuentes familiarizadas con el acuerdo, la inversión de capital de NVIDIA se realizará en fases junto con el despliegue de la infraestructura, con aproximadamente 10 mil millones de dólares comprometidos en el hito del primer gigavatio. Este enfoque transforma eficazmente a NVIDIA de un proveedor de hardware tradicional en un socio de capital estratégico, compartiendo tanto los riesgos como las recompensas de los ambiciosos planes de escalamiento de OpenAI.

Rompiendo el Ciclo de Dependencia de la Nube

El acuerdo representa un giro estratégico para OpenAI, que históricamente ha dependido en gran medida de la infraestructura en la nube Azure de Microsoft tras la inversión inicial de 13 mil millones de dólares del gigante del software. Al asegurar acceso directo a hardware de vanguardia a través de la asociación con NVIDIA, OpenAI obtiene una palanca de negociación crucial y una diversificación de la cadena de suministro.

La dependencia de un proveedor (vendor lock-in) en la computación en la nube se refiere a la sujeción de un cliente a un único proveedor, lo que hace que sea difícil y costoso cambiar a otro. Esto crea riesgos como una flexibilidad limitada y un potencial aumento de los gastos. Las estrategias multinube a menudo se adoptan para mitigar tales dependencias de un único proveedor.

Los observadores del mercado señalan que este acuerdo complementa, en lugar de reemplazar, las relaciones existentes de OpenAI. La compañía continúa colaborando con Oracle a través de la iniciativa Stargate y mantiene su asociación con Microsoft, creando un enfoque de múltiples proveedores que reduce los riesgos de dependencia de una única fuente.

"OpenAI está creando esencialmente competencia de proveedores para su recurso más crítico", señaló un analista de la industria que solicitó el anonimato debido a las relaciones con sus clientes. "Esto podría alterar fundamentalmente la dinámica de precios en la infraestructura de IA."

La Gran Carrera Armamentística de la Infraestructura de IA

La asociación NVIDIA-OpenAI llega en medio de una transformación más amplia de la industria hacia implementaciones masivas de computación de IA. Meta ha discutido públicamente clústeres de múltiples gigavatios para sus ambiciones de IA, mientras que xAI de Elon Musk ha construido rápidamente la instalación de supercomputadoras "Colossus". Microsoft anunció recientemente planes para su centro de datos Fairwater en Wisconsin, que implica una inversión estatal de más de 7 mil millones de dólares.

Este escalamiento de infraestructura refleja un cambio fundamental en la filosofía de desarrollo de la IA. A diferencia de paradigmas de computación anteriores centrados en la eficiencia algorítmica, el progreso actual de la IA depende cada vez más de la escala computacional bruta. Entrenar modelos más capaces requiere clústeres de GPU exponencialmente más grandes, creando una barrera intensiva en capital que favorece a los actores bien financiados.

Gastos de capital proyectados en infraestructura de IA por parte de las principales empresas tecnológicas, destacando la creciente 'carrera armamentística'.

| Empresa | Gasto Proyectado en Infraestructura de IA | Plazo/Notas |

|---|---|---|

| Microsoft | 80 mil millones de USD | Año Fiscal 2025 |

| 120 mil millones de USD | Año Fiscal 2026 | |

| 100 mil millones de USD | Próximo año fiscal (a partir de agosto de 2025) | |

| Meta | 60 - 65 mil millones de USD | Gastos de capital de 2025 |

| 66 - 72 mil millones de USD | Próximo año fiscal (a partir de agosto de 2025) | |

| 100 mil millones de USD | Insinuado para inversión empresarial del Año Fiscal 2026 | |

| xAI | 13 mil millones de USD | Plan de gastos de 2025, incluye la supercomputadora Colossus |

| Decenas de miles de millones de USD | Costo estimado para la supercomputadora Colossus 2 | |

| Amazon | 100 mil millones de USD | Gastos de capital proyectados para 2025 |

| 118 mil millones de USD | Cantidad esperada para el gasto de 2025 (a partir de agosto de 2025) | |

| Alphabet (Google) | 75 mil millones de USD | Gastos de capital proyectados para 2025 |

| 85 mil millones de USD | Esperado para el próximo año fiscal (a partir de agosto de 2025) |

Las limitaciones energéticas han surgido como el principal cuello de botella en lugar de la disponibilidad de chips. Asegurar energía confiable y asequible —particularmente de fuentes renovables— se ha vuelto tan crítico como las cadenas de suministro de semiconductores. Las empresas deben sortear complejos procesos de permisos, limitaciones de infraestructura de transmisión y regulaciones ambientales en múltiples jurisdicciones.

Implicaciones de Inversión en Todo el Stack Tecnológico

Es probable que los mercados financieros vean esta asociación como una validación de varios temas de inversión. Las acciones de NVIDIA ya se han beneficiado de la demanda de infraestructura de IA, pero este acuerdo proporciona una visibilidad de ingresos sin precedentes que se extiende hasta 2029. La estructura de inversión por etapas también posiciona a NVIDIA para capturar el potencial al alza del éxito de OpenAI mientras mitiga los riesgos a la baja.

La asociación crea un efecto dominó en toda la cadena de suministro tecnológica. Los proveedores de memoria de alto ancho de banda, incluidos SK Hynix, Micron y Samsung, se beneficiarán de la demanda sostenida, aunque podrían surgir presiones de precios para 2026 a medida que se expanda la capacidad de producción. Los especialistas en empaques avanzados y los servicios de fundición, particularmente Taiwan Semiconductor Manufacturing Company, enfrentan continuas limitaciones de capacidad para apoyar la producción acelerada de chips.

Las empresas de infraestructura energética y energía renovable podrían experimentar una mayor atención de los inversores a medida que las empresas de IA buscan acuerdos de energía dedicados. Algunos analistas sugieren que esto podría acelerar la adopción de pequeños reactores nucleares modulares y soluciones de almacenamiento de energía a escala de red diseñadas específicamente para cargas de computación de alta densidad.

Navegando Vientos en Contra Regulatorios y Técnicos

La asociación enfrenta varios factores de riesgo significativos que podrían afectar los plazos de ejecución y los rendimientos financieros. El escrutinio regulatorio parece cada vez más probable a medida que las autoridades antimonopolio examinan las implicaciones competitivas de que los proveedores de hardware tomen posiciones de capital en clientes importantes mientras dominan la cuota de mercado.

Las preocupaciones ambientales sobre el consumo de energía para el entrenamiento de IA podrían provocar intervenciones políticas que limiten las asignaciones de energía o impongan mecanismos de fijación de precios del carbono. El uso de agua para sistemas de enfriamiento y el uso de la tierra para la construcción de centros de datos pueden enfrentar oposición local en los mercados geográficos preferidos.

Los riesgos técnicos incluyen posibles avances en arquitecturas de computación alternativas que podrían reducir las ventajas competitivas de NVIDIA. Los desarrollos de silicio personalizado por parte de los proveedores de la nube o los avances en la computación cuántica podrían interrumpir las dependencias de hardware actuales, aunque tales transiciones suelen requerir varios años para materializarse.

Los Pequeños Reactores Modulares (SMRs) son reactores nucleares avanzados y compactos diseñados para la generación de energía eficiente y modular. Estas unidades se están explorando cada vez más como una fuente de energía confiable y libre de carbono para aplicaciones de alta demanda, incluyendo el suministro de energía a los vastos centros de datos críticos para la infraestructura de inteligencia artificial.

La Pregunta del Billón de Dólares: ¿Qué Sigue?

Esta asociación señala que el desarrollo de la IA ha entrado en una nueva fase donde el éxito depende tanto de las capacidades de infraestructura como de la innovación algorítmica. Las empresas dispuestas y capaces de destinar cientos de miles de millones a la infraestructura informática pueden determinar qué sistemas de IA lograrán finalmente una implementación generalizada.

Los observadores del mercado deben monitorear varios indicadores clave en los próximos meses: los términos definitivos del acuerdo, los acuerdos de compra de energía para ubicaciones específicas de centros de datos y la evidencia de asociaciones similares entre empresas de IA competidoras. El ritmo de desarrollo de la plataforma Vera Rubin y las primeras implementaciones comerciales proporcionarán señales tempranas sobre las capacidades de ejecución.

Para los inversores, la asociación NVIDIA-OpenAI representa tanto una oportunidad como un riesgo de concentración. Si bien extiende el liderazgo de NVIDIA en infraestructura de IA durante la década, también aumenta la dependencia de una relación con un solo cliente que podría enfrentar desafíos regulatorios o interrupciones técnicas.

La implicación más amplia se extiende más allá de los mercados financieros a preguntas sobre la concentración del desarrollo de la IA entre un pequeño número de entidades bien capitalizadas. A medida que los requisitos de infraestructura crecen exponencialmente, el número de organizaciones capaces de entrenar sistemas de IA de vanguardia puede disminuir, afectando potencialmente la diversidad de innovación y la dinámica competitiva en la inteligencia artificial.

Tesis de Inversión de la Casa

| Categoría | Detalles del Resumen |

|---|---|

| Visión Ejecutiva | Una verticalización de función escalonada donde NVIDIA se convierte en un socio de capital para asegurar cargas de trabajo clave de IA. OpenAI obtiene una pista de computación a varios años y apalancamiento de proveedores. La escala prioriza la energía (10 GW ≈ 87.6 TWh/año, alimentando ~6-10M aceleradores), haciendo que la adquisición de energía sea el factor limitante. ~70% de probabilidades de un acuerdo definitivo, con deslizamiento en el cronograma más probable que la cancelación. |

| Novedades | 100 mil millones de USD de NVIDIA, basados en el progreso (ej., 10 mil millones de USD por 1 GW con una valoración de OpenAI de ~500 mil millones de USD). Costo total de infraestructura hasta 400 mil millones de USD. Objetivo de 10 GW, primera ola en la plataforma "Vera Rubin" a partir del S2 de 2026. El acuerdo no es exclusivo, complementando otros planes de OpenAI (ej., Stargate con Oracle) y reequilibrando su dependencia de Microsoft. |

| Tendencia vs. Excepción | Tendencia: Las fábricas de IA de múltiples gigavatios son la nueva unidad competitiva (ejemplos: OpenAI-Oracle Stargate, Microsoft Fairwater, Meta, xAI). Excepción: La escala de un proveedor (NVIDIA) invirtiendo capital en un cliente (OpenAI) para verticalizar la economía y elevar el costo de capital de los rivales. |

| Cálculo de Escala (Estimaciones) | Energía: 10 GW = 87.6 TWh/año. Gastos Operacionales (Opex): 2.6 mil millones de USD - 8.8 mil millones de USD/año solo en energía. Aceleradores: ~5.6M-10.4M GPU. TAM de Hardware Implícito: Potencial de ingresos acumulados de la industria de 300 mil millones de USD - 600 mil millones de USD. |

| Economía y P&L - NVIDIA | Ingresos: 300 mil millones de USD - 500 mil millones de USD en ventas acumuladas de 6-9M aceleradores durante 3-5 años. Margen: Altamente acrecentador, con un margen bruto reciente de ~72-76%; el cambio de mezcla hacia sistemas podría moderar el margen bruto máximo. Risks: Concentración de clientes, antimonopolio, cadena de suministro y retrasos en la ubicación de energía. |

| Economía y P&L - OpenAI | Victoria Estratégica: Fuentes de computación diversificadas, co-optimización de la hoja de ruta y competencia de proveedores. Estructura de Capital: La realineación sin fines de lucro/Microsoft más la participación de capital de NVIDIA añade un pilar no controlador. El riesgo de ejecución sigue siendo alto. |

| Beneficiarios de Segundo Orden | Proveedores de HBM (SK hynix, Micron, Samsung); Empaques avanzados (TSMC, ASE, Amkor); Empresas de servicios públicos de energía y red; OEMs de sistemas y redes (ej., Supermicro). |

| Causas Raíz | 1. La computación es el factor limitante para la calidad del modelo. 2. La energía es el cuello de botella. 3. Necesidad de co-diseño HW-SW. 4. Incentivos geopolíticos/de relocalización (onshoring). |

| Riesgos | Regulatorios: Escrutinio antimonopolio. Ejecución: Retrasos en la ubicación/permisos de energía. Tecnológicos: Silicio personalizado exitoso o eficiencia algorítmica reduce la demanda de FLOP. Financiación: Presión política por la óptica de "circularidad". |

| Escenarios (Probabilidades) | Base (55%): Acuerdo definitivo en 3-6 meses; despliegues por etapas con deslizamientos parciales. Alcista (25%): Avances en la ubicación de energía, suministro de HBM más holgado, mejor rendimiento de la plataforma. Bajista (20%): Retrasos antimonopolio/energéticos >18 meses, disputas sobre la estructura de capital de OpenAI. |

| Próximo Seguimiento | Acuerdos de Compra de Energía (PPAs) firmados y detalles de interconexión; capacidad y precios de HBM; términos definitivos del acuerdo (capital, gobernanza, compromisos); puntos de prueba de entrega (fechas de envío de Rubin, escala de clúster); mezcla de nube de OpenAI para entrenamiento. |

| Consideraciones de Posicionamiento | Núcleo: NVIDIA como índice de la computación de IA con visibilidad de demanda hasta 2028-29. Picos y Palas: Sobreponderar HBM, empaques, infraestructura energética. Coberturas: Monitorear el silicio personalizado y las incertidumbres regulatorias. |

El rendimiento pasado no garantiza resultados futuros. Los inversores deben consultar a asesores financieros para obtener orientación personalizada basada en sus circunstancias individuales y tolerancia al riesgo.