Google DeepMind Presenta Gemini Diffusion: Un Cambio de Paradigma en la Generación de Texto por IA

Google DeepMind anunció ayer Gemini Diffusion, un modelo de lenguaje experimental que aplica el enfoque de ruido a señal de la generación de imágenes al texto por primera vez a escala de producción. Este avance promete una generación de texto significativamente más rápida con una coherencia mejorada, lo que podría revolucionar el enfoque dominante en los modelos de lenguaje grandes que ha definido el desarrollo de la IA durante años.

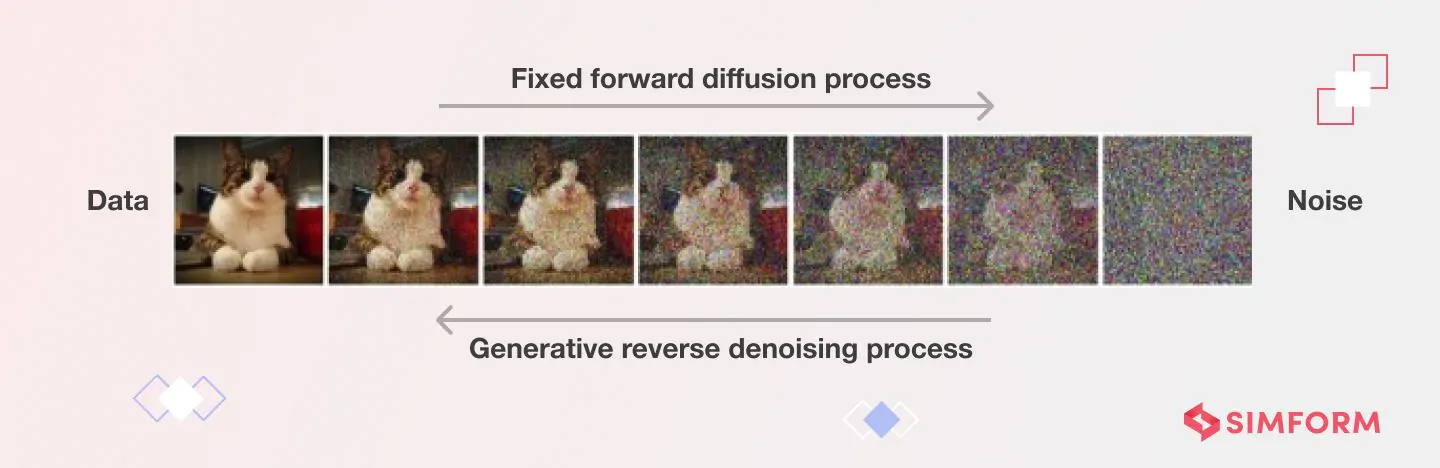

A diferencia de los modelos autorregresivos convencionales que generan texto token a token, Gemini Diffusion funciona refinando el ruido para convertirlo en texto coherente a través de pasos iterativos, un proceso que, según Google, ofrece respuestas "significativamente más rápidas que incluso nuestro modelo más rápido hasta ahora".

"Esto representa un cambio fundamental en cómo pensamos sobre la generación de lenguaje", dijo un investigador sénior de IA familiarizado con la tecnología de difusión pero no afiliado a Google. "Estamos viendo el potencial de una mejora de 4 a 5 veces en la velocidad de salida de extremo a extremo en comparación con modelos autorregresivos de tamaño similar. Es como saltarse varias generaciones de hardware solo a través de la innovación de software".

Rompiendo la Barrera Secuencial

La innovación técnica detrás de Gemini Diffusion aborda una limitación principal de los sistemas de IA actuales. Los modelos de lenguaje tradicionales como GPT-4 o versiones anteriores de Gemini funcionan de forma secuencial, prediciendo cada palabra basándose en lo que vino antes. Este enfoque, aunque efectivo, limita intrínsecamente la velocidad y puede generar problemas de coherencia en salidas más largas.

Los modelos de difusión adoptan un enfoque radicalmente diferente. En lugar de construir texto pieza a pieza, comienzan con ruido aleatorio y lo refinan gradualmente para convertirlo en contenido significativo a través de pasos repetidos de eliminación de ruido (denoising).

"Todo el proceso es más como esculpir que como escribir", explicó un analista de la industria especializado en arquitecturas de IA. "El modelo considera el contexto completo en cada etapa de refinamiento, lo que permite de forma natural la corrección de errores y una coherencia holística que es más difícil de lograr con la generación token a token".

Los resultados de las pruebas de rendimiento (benchmarks) publicados por Google muestran que Gemini Diffusion alcanza una velocidad de muestreo promedio de 1.479 tokens por segundo, una mejora sustancial con respecto a modelos anteriores, aunque esto viene con aproximadamente 0,84 segundos de sobrecarga para cada generación.

Rendimiento Mixto en las Pruebas de Rendimiento Revela Fortalezas y Limitaciones

Los datos de las pruebas de rendimiento de Google revelan el perfil de rendimiento desigual pero prometedor de Gemini Diffusion. El modelo muestra una fortaleza particular en tareas de codificación, obteniendo un 89,6% en HumanEval y un 76,0% en MBPP, virtualmente idéntico a las puntuaciones de Gemini 2.0 Flash-Lite de 90,2% y 75,8%, respectivamente.

Sin embargo, el modelo muestra debilidades notables en ciertas áreas. En la prueba de razonamiento BIG-Bench Extra Hard, Gemini Diffusion obtuvo un 15,0% en comparación con el 21,0% de Flash-Lite. De manera similar, en la prueba multilingüe Global MMLU, Diffusion logró un 69,1% frente al 79,0% de Flash-Lite.

"Lo que estamos viendo es una tecnología que destaca en tareas que requieren refinamiento iterativo, como la codificación, donde los pequeños ajustes localizados dentro de un contexto global son valiosos", señaló un experto en aprendizaje automático de una importante institución financiera. "El rendimiento más débil en tareas de razonamiento sugiere que la difusión podría necesitar un ajuste de arquitectura para aplicaciones con mucha lógica".

A pesar de estas limitaciones, Google DeepMind destaca la eficiencia de parámetros del modelo, logrando puntuaciones de rendimiento comparables a modelos autorregresivos más grandes en muchos dominios.

Desafíos Técnicos en el Diseño e Implementación de Modelos de Difusión de Texto

| Categoría del Desafío | Desafío Específico | Descripción |

|---|---|---|

| Computacional y Eficiencia | Demandas de Procesamiento | Requiere cientos a miles de pasos de eliminación de ruido (denoising), cada uno involucrando una pasada completa hacia adelante a través de una red neuronal |

| Problemas de Latencia | La inferencia puede ser notablemente lenta, limitando aplicaciones en tiempo real | |

| Consumo de Memoria | Requisitos de memoria significativos con grandes mapas de características intermedias durante cada paso de difusión inversa | |

| Implementación Específica para Texto | Limitaciones de Arquitectura | No puede beneficiarse del KV-caching debido al cálculo de atención no causal |

| Limitaciones de la Transición Q_absorb | Elimina el ruido de los tokens solo una vez, limitando la capacidad de editar tokens generados previamente | |

| Ineficiencias de Procesamiento | Los tokens enmascarados no proporcionan información pero aún consumen recursos computacionales | |

| Longitud de Generación Fija | Principal obstáculo para la generación de texto abierta (sin límite) en comparación con modelos autorregresivos | |

| Control y Alineación | Problemas de Precisión del Texto | Dificultad para adherirse al conjunto completo de condiciones especificadas en el texto de entrada |

| Problemas de Fidelidad | A menudo generan contenido con significado o detalles incorrectos a pesar de una salida de aspecto natural | |

| Salidas Inconsistentes | Diferentes muestras aleatorias pueden producir resultados muy diferentes con la misma instrucción (prompt) | |

| Renderizado de Texto | Dificultad para renderizar texto correcto y controlar el estilo del texto en la generación de imágenes | |

| Teórico y Aprendizaje | Desafíos de la Función de Puntuación (Score Function) | El rendimiento está ligado a aprender con precisión la función de puntuación |

| Equilibrio de Compromisos | Encontrar el equilibrio óptimo entre velocidad, costo y calidad sigue sin resolverse | |

| Despliegue | Limitaciones de Recursos | Rendimiento de cómputo limitado, capacidad de memoria y presupuesto de energía en dispositivos de borde (edge devices) |

| Gestión Térmica | Muchos dispositivos dependen de refrigeración pasiva, lo que hace poco prácticas las cargas de trabajo sostenidas de alto rendimiento | |

| Integración en Producción | El manejo de latencia variable y el alto uso de memoria complican la integración del sistema | |

| Preocupaciones de Seguridad | Prevenir el uso indebido requiere salvaguardas robustas que añaden sobrecarga | |

| Control de Versiones | Las actualizaciones pueden romper aplicaciones posteriores al hacer ajuste fino para casos de uso específicos |

Edición y Refinamiento: Una Nueva Fortaleza de la IA

Quizás la ventaja más significativa del enfoque de difusión es su aptitud natural para las tareas de edición y refinamiento.

"En cada paso de eliminación de ruido, el modelo puede autoc corregir errores fácticos o sintácticos", dijo un profesor de ciencias de la computación que estudia la IA generativa. "Esto hace que la difusión sea particularmente potente para tareas como derivaciones matemáticas o correcciones de código, donde se necesita mantener la consistencia a través de relaciones complejas".

Esta capacidad de autocorrección ofrece una solución potencial a desafíos como las alucinaciones y la deriva que han afectado a los modelos de lenguaje grandes. Al considerar la salida completa en cada paso en lugar de solo los tokens precedentes, Gemini Diffusion puede mantener una mejor coherencia en pasajes más largos.

Acceso Anticipado e Implicaciones Futuras

Google ha abierto una lista de espera para desarrolladores interesados en probar Gemini Diffusion, describiéndolo como "una demostración experimental para ayudar a desarrollar y refinar modelos futuros".

Para usuarios profesionales e inversores, las implicaciones van mucho más allá de un simple lanzamiento de producto. Los modelos de difusión podrían alterar fundamentalmente el panorama de la IA si continúan demostrando ventajas en velocidad y calidad.

"Potencialmente estamos viendo el comienzo de una era híbrida", sugirió un estratega de inversión en IA de un importante fondo de inversión libre. "Los próximos dos años podrían estar dominados por modelos que combinen la velocidad y coherencia de la difusión con las fortalezas de razonamiento token a token de los enfoques autorregresivos".

La tecnología parece especialmente prometedora para herramientas de edición interactivas, donde los usuarios podrían refinar las salidas de la IA a mitad de generación o aplicar restricciones de forma dinámica. Esto podría permitir un control más preciso que la ingeniería de prompts actual de una sola vez.

Implicaciones para el Mercado del Cambio hacia la Difusión

Para los traders e inversores que siguen el espacio de la IA, Gemini Diffusion representa tanto oportunidad como disrupción.

"Esta innovación modifica la curva de costos para la inferencia a escala", dijo un analista del sector tecnológico. "Las empresas fuertemente invertidas en infraestructura optimizada para modelos autorregresivos podrían necesitar cambiar de rumbo, mientras que aquellas que trabajan en capacidades de edición y experiencias de IA interactivas podrían ver fortalecido su posicionamiento".

El anuncio señala una competencia intensificada en la carrera de la IA, con Google aprovechando su profundidad de investigación para diferenciar sus ofertas de OpenAI, Anthropic y otros. Para los clientes empresariales, la promesa de una generación más rápida con calidad comparable podría reducir significativamente los costos de computación.

Sin embargo, quedan barreras significativas antes de que los modelos de difusión puedan convertirse en algo generalizado. El ecosistema de herramientas, auditorías de seguridad y mejores prácticas de despliegue para la difusión de texto sigue siendo mucho menos maduro que para los modelos autorregresivos. Los adoptadores tempranos pueden enfrentar desafíos de integración y calidad desigual en distintos dominios.

"La gran pregunta es si la difusión de texto es el futuro o solo un componente importante de él", observó un experto en gobernanza de IA. "El éxito probablemente pertenecerá a los sistemas que combinen difusión con razonamiento token a token, recuperación y capas de seguridad robustas".