Anthropic Presenta Claude Sonnet 4.5: Más Rápido, Más Inteligente, Pero Aún Segundo en la Carrera de Codificación

El nuevo LLM muestra un progreso real en tareas largas y complejas y en el soporte de codificación, pero aún le cuesta igualar a GPT-5 Codex en los problemas más difíciles.

SAN FRANCISCO — Anthropic lanzó el lunes su último modelo de IA, Claude Sonnet 4.5, con afirmaciones audaces. La empresa lo calificó como “el mejor modelo de codificación del mundo”. Pero un análisis más detallado cuenta una historia diferente. Sí, el modelo es más rápido y más resistente que sus predecesores. Sin embargo, pruebas independientes muestran que aún no alcanza a GPT-5 Codex de OpenAI en áreas clave que más importan a los desarrolladores profesionales.

El lanzamiento se produjo apenas cuatro meses después de Sonnet 4, un recordatorio de la rapidez con la que las empresas de IA compiten por superarse entre sí. Anthropic y OpenAI ahora lanzan actualizaciones importantes casi cada trimestre. Los observadores notaron que Anthropic a menudo programa sus anuncios para eclipsar a OpenAI. Por ejemplo, Opus 4.1 de Anthropic se lanzó justo antes de que GPT-5 saliera en agosto.

Construido para la Resistencia, No Solo la Velocidad

Anthropic está apostando fuerte por la resistencia. Según las pruebas de la compañía, Sonnet 4.5 puede abordar proyectos de codificación complejos durante más de 30 horas seguidas sin perder la concentración. Eso es un gran avance respecto a los modelos anteriores, que tendían a desviarse de la tarea durante sesiones largas.

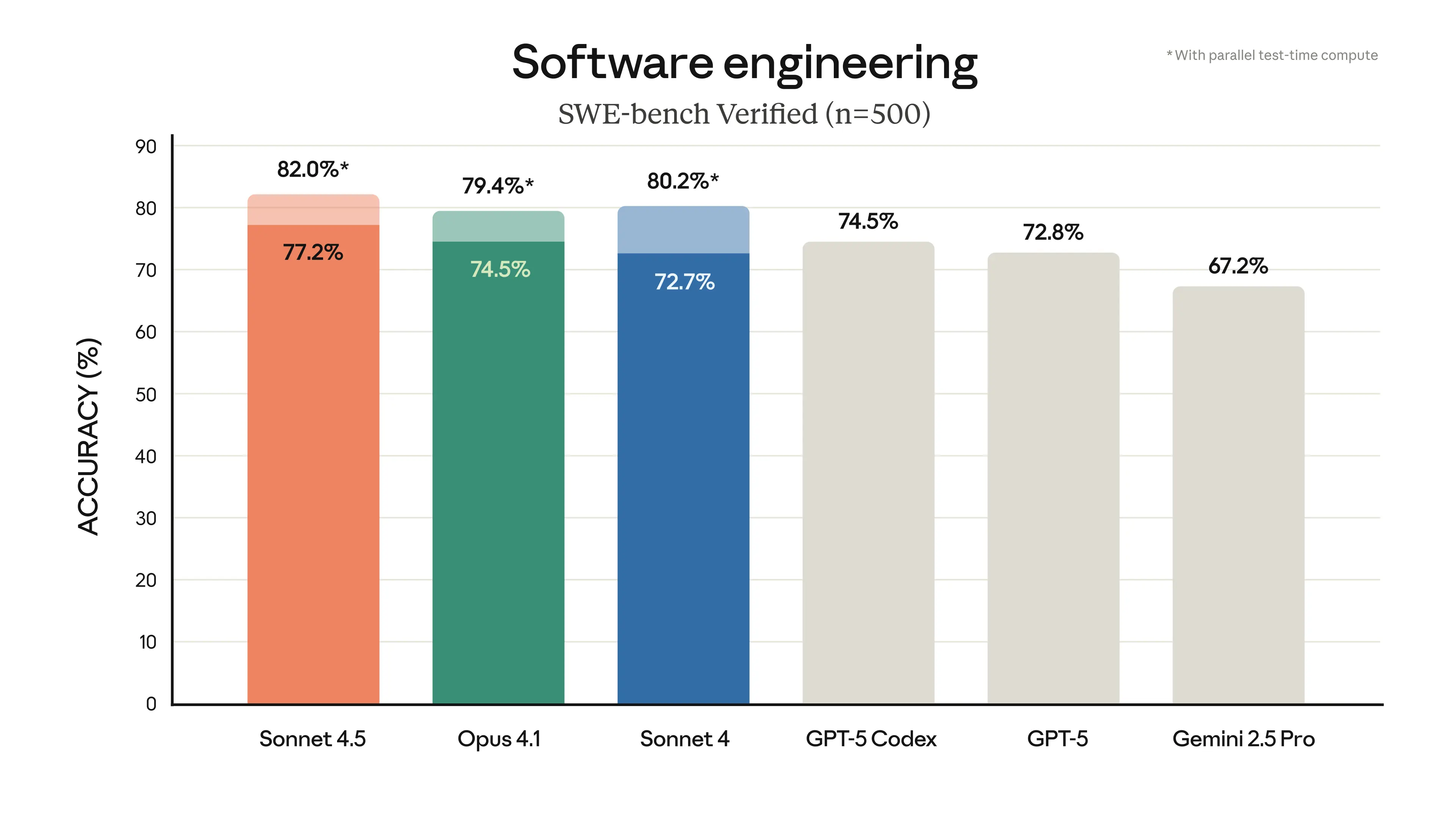

Las cifras lo respaldan. En SWE-bench Verified —un benchmark que mide el rendimiento de ingeniería de software en el mundo real—, Sonnet 4.5 obtuvo una puntuación más alta que cualquier modelo anterior de Anthropic. En OSWorld, que prueba qué tan bien la IA puede manejar sistemas informáticos completos, saltó del 42.2 por ciento en junio al 61.4 por ciento actualmente.

En la práctica, esto significa que el modelo ahora puede hacer más que solo escribir código. Puede navegar por navegadores web, rellenar hojas de cálculo e incluso completar formularios en línea extensos utilizando la extensión de Chrome de Anthropic. Los desarrolladores también obtienen nuevas herramientas como puntos de control (checkpoints) en Claude Code, que les permiten guardar el progreso sin Git, un terminal más pulido y una integración nativa con Visual Studio Code.

La Prueba de la Realidad

Ingenieros de nuestro equipo de ingeniería CTOL.digital elogiaron su velocidad y fiabilidad para el trabajo diario: tareas como revisar pull requests, depurar y manejar proyectos con múltiples archivos. La función de puntos de control (checkpoint) en particular fue muy bien recibida.

Pero la luna de miel terminó cuando le pidieron que abordara desafíos más difíciles. El trabajo complejo de front-end lo hizo tropezar. En algunos casos, ignoró la estructura existente o la configuración de autenticación de un proyecto, lo que puede romper aplicaciones de maneras que ningún desarrollador desea.

“Para la codificación diaria, es excelente”, explicó un ingeniero de nuestro equipo de ingeniería. “Pero cuando nos enfrentamos a complejos acertijos lógicos o a molestos errores de producción, GPT-5 Codex sigue siendo nuestra primera opción.”

¿La conclusión? Muchos miembros del equipo se encuentran ejecutando un sistema de dos modelos: utilizando Sonnet 4.5 para tareas rutinarias y dejando el trabajo difícil a GPT-5. Ese enfoque podría equilibrar los costos y la productividad hasta que Anthropic reduzca la brecha.

Construyendo para el Futuro de los Agentes

Más allá del modelo en sí, Anthropic está sentando discretamente las bases para algo más grande. La compañía acaba de lanzar el SDK de Agentes Claude, el mismo conjunto de herramientas detrás de Claude Code. Con él, los desarrolladores pueden construir agentes autónomos que manejen trabajos de larga duración, gestionen permisos y se coordinen entre múltiples subagentes.

Anthropic también está ejecutando una demostración de cinco días “Imagine with Claude” para usuarios premium. En ella, Sonnet 4.5 construye software real y funcional desde cero, en vivo y sin guion. Aunque se presenta como un experimento, insinúa la ambición de la compañía de ir más allá de los asistentes de codificación y avanzar hacia colaboradores de IA completos.

Los precios se mantienen igual —3 dólares por millón de tokens de entrada y 15 dólares por millón de tokens de salida—, manteniendo a Claude firmemente en el nivel premium mientras los competidores reducen las tarifas.

La Seguridad Sigue Siendo Prioritaria

Anthropic no ha olvidado la alineación. Sonnet 4.5 se presenta como su modelo más seguro hasta la fecha, mostrando menos signos de adulación, engaño u otros comportamientos de riesgo. También resiste mejor que antes los ataques de inyección de prompts, lo cual es crucial cuando los agentes operan dentro de sistemas reales.

El modelo se entrega con protecciones de Nivel 3 de Seguridad de IA, incluyendo filtros que detectan entradas peligrosas relacionadas con el desarrollo de armas. Esos filtros a veces bloquean material inofensivo, pero Anthropic afirma que las falsas alarmas han disminuido diez veces desde las versiones anteriores.

Presión por Todos Lados

La supervivencia de Anthropic parece menos precaria después de este lanzamiento, pero la amenaza persiste. Ya ha perdido su posición como joya de la corona de ser el mejor LLM de codificación; nuestros problemas más difíciles ahora solo son resolubles con GPT-5 High/Pro. En este punto, Anthropic solo puede competir en precio y en casos de uso diario. Pero si Gemini 3 supera a Sonnet 4.5 en codificación y además es más barato —permaneciendo en la frontera de Pareto—, Anthropic podría estar en serios problemas, ya que la mayor ventaja de sus modelos hasta ahora ha sido en las tareas de codificación diarias.

Inversores, Tomen Nota

Para los inversores, el mensaje es claro: el mercado de los modelos de lenguaje grandes está madurando rápidamente. Las ganancias son ahora incrementales, y la verdadera diferenciación pronto podría provenir de la integración, la dependencia del ecosistema o el ajuste fino específico de la industria, no del poder bruto.

Los desarrolladores, mientras tanto, es poco probable que se queden con un solo proveedor. La jugada más inteligente es mezclar y combinar modelos según la tarea. Eso podría reducir los beneficios para los creadores de modelos, pero crear oportunidades para las empresas que desarrollan herramientas de orquestación por encima.

El riesgo es mayor para las empresas que solo venden modelos fundacionales. A medida que las características convergen y los clientes cambian fácilmente, el poder de fijación de precios puede colapsar mucho antes de que lo hagan los costos operativos. Los hyperscalers, con sus profundos bolsillos y sus paquetes de servicios en la nube, podrían acelerar esa tendencia.

Descargo de Responsabilidad: Este artículo refleja las condiciones actuales y los patrones del mercado. Los resultados pasados no garantizan el rendimiento futuro. Se recomienda a los lectores buscar asesoramiento financiero independiente antes de tomar decisiones de inversión.